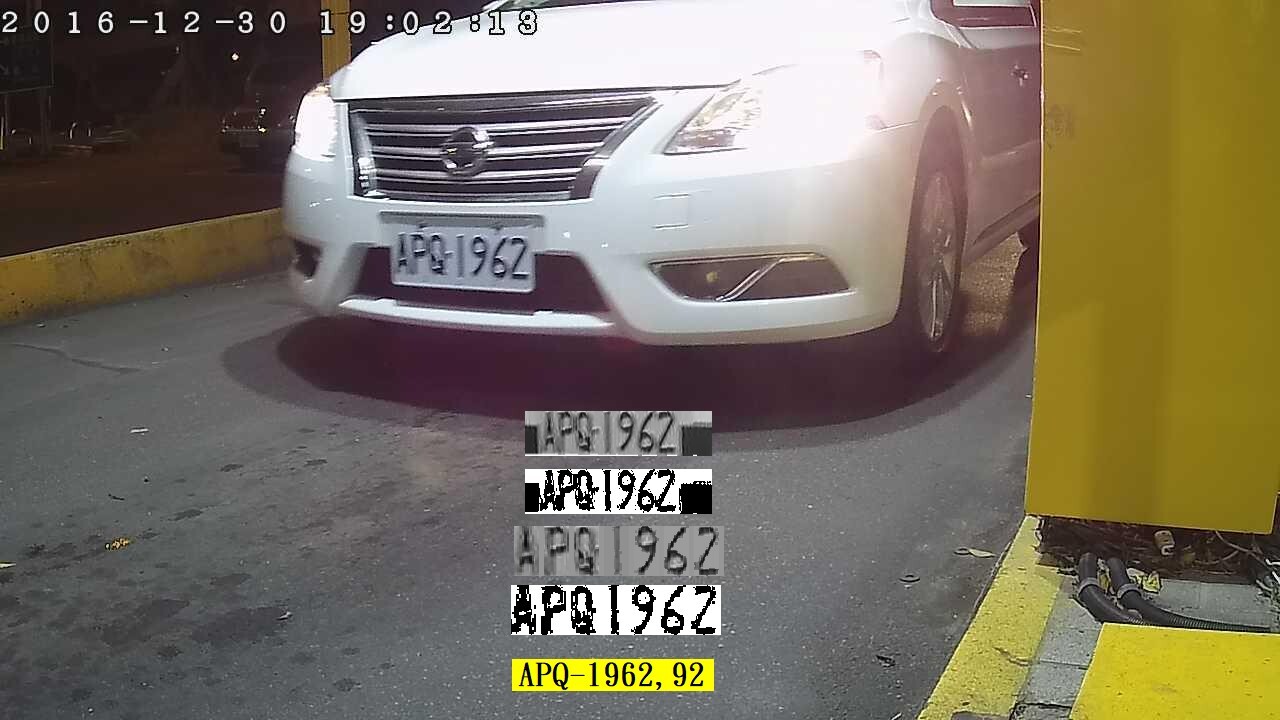

我最近的車牌辨識研究中一個很大的突破,就是我在我的多處理程序之中,正式加入了影像銳利化的步驟!主要是針對如上因為攝影失焦、環境煙霧或照明昏暗造成的模糊影像!也確實大幅提高了這類模糊影像的辨識成功率!我之前一直跟客戶說:人眼辨識的抗模糊能力比一般辨識軟體好很多!現在這種差距就被我拉近了!

OCR辨識程序中很重要的關鍵,就是二值化的切割能否盡量正確的切割出目標字元!但是影像一模糊就會讓字元邊界模糊,常常就會讓字元與其他字元或背景目標沾連了!所以我的辨識失敗資料庫中有一大堆如上這種讓人扼腕的,差一點就可以辨識成功的案例!

傳統影像辨識中,碰到影像模糊的應對方式當然就是銳利化處理!演算方式還有很多種,使用過PhotoShop軟體的人應該都知道!但實務上非常少人會在車牌辨識SOP中使用軟體層級的銳利化處理!我之前也嘗試過,一方面會拖慢辨識速度,一方面銳利化也是兩面刀!可能讓沾連的目標分開,也可能將略模糊的單一目標被意外分裂了!

所以我之前賣出的軟體其實一直都是不包含銳利化處理的!但是近幾年我的基礎處理速度效能大幅提高了!也讓我可以有空間加入較多樣化的處理程序,就是無法辨識出有意義結果時,可以用多種不同策略對付難辨識的影像!最近就是加入了X方向與Y方向的兩種銳利化處理,X方向銳利化可以協助分割字元之間的沾連,Y方向銳利化則可以協助分割字元與背景之間的沾連,各有其用處。

如上圖所示,圖左是模糊的原影像,中間是經過X方向銳利化之後的二值化圖,右方是經過Y方向銳利化之後的二值化圖!X方向銳利化會產生較多垂直向的紋路,Y方向銳利化則會產生較多水平向的紋路!這些是副作用,但對於模糊影像而言,多切割出一個正確字元常常就是可以幫我完成辨識的臨門一腳了!下面案例就可以看到過程圖中X方向銳利化處理留下的垂直向紋路。

所以我的影像辨識算是延續傳統影像辨識的技術方向繼續挺進之中!但是現在常用的CNN技術思考方向就完全不同了!他們傾向完全不對原始影像做任何影像處理,而是用特徵矩陣的設計與掃描蒐集現狀的特徵來繼續後續的辨識流程。好處是不會讓影像失真,也省下了一些影像處理的時間。

但他們會這麼作的真正原因絕對不是怕影像失真或想節省時間!因為一旦使用了ML、DL或CNN,需要的計算量與時間就已經是傳統影像處理(如銳利化)的數十倍了!他們的主要考量只是刻意躲開了應該做何種影像處理?才能真正提高辨識率的專業問題!如銳利化等影像處理其實就像人生病時醫師開的藥,當然不是隨便甚麼人吃了都有用的!吃錯藥會比不吃藥更糟糕!所以才必須有醫學專業知識的醫師來開藥嘛!

但是現在的AI影像辨識發展方向應該是太急功好利了!不願意像前人一樣,務實研究甚麼影像應該做甚麼處理的專業問題,妄想用不需要專業知識的數學(統計)方法就可以直接解決所有問題?機器學習與深度學習就是在這種思維下被採用的工具了!但是這些「不知而行」的抓瞎技術,真的可以取代真正影像辨識專家能做的工作嗎?

統計學畢竟不是準確與精密的科學,所以這些XX學習雖然在很多議題上可以快速取得大致接近人為辨識能力的成果,但是通通會陷入無法繼續精進提高辨識率的泥潦!繼續投入更多的資料,與使用更多的計算程序與設備都是漫無方向的飲鴆止渴而已!根本沒用的!以我的專業角度來看是心驚膽顫加上嘆息不已!心驚的是那要耗費多少無謂的資源?嘆息的是會有多少軟體公司會被這個迷思拖垮而破產倒閉?

我只能慶幸自己在以深度學習作影像辨識的大騙局成形之前,就已經用正常的傳統也有效的方式做出很好的影像辨識產品了!所以我不需要ML、DL與CNN等技術就已經能在影像辨識業界如魚得水了!所以我始終沒有因為投入這個無效的影像辨識技術騙局而受到傷害!就是花很多錢卻沒有成效啦!

我目前能盡到的專業與社會責任就是把自己堅持的技術方向做得更好,走得更遠!讓大家知道做影像辨識根本不需要ML、DL與CNN!也明確分析事實與學理,讓使用ML、DL與CNN做影像辨識的這個世紀大騙局的災情盡量降低了!

限會員,要發表迴響,請先登入